Tekijä: Joonas Äijälä

Haavoittuva tekoäly

Onko tekoälypöhinä jäänyt lähtökuoppiinsa?

Neljä syytä, miksi datasi kannattaisi olla Azuressa

Ignite 2021 BI ja AI parhaat palat

Building a secure Azure data platform

Consolidating our enterprise data in the Azure Data Lake to enrich our data-driven solutions

Automated Machine Learning has hit GA – and why it matters

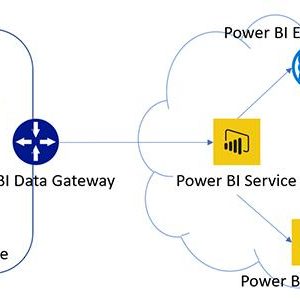

Building a real-time, cloud-based monitoring solution using Power BI and Microsoft’s data offerings